И.Н. Бекман

ИНФОРМАЦИЯ, ИНФОРМАТИКА И ИНФОРМАЦИОННЫЕ ТЕХНОЛОГИИ

Лекция 2. ИНФОРМАЦИЯ

2.4 Количество информации

Понятно, что измерить количество смысловой информации невозможно. Какое количество информации содержится, к примеру, в тексте романа «Война и мир», во фресках Рафаэля или в генетическом коде человека? Ответа на эти вопросы наука не даёт и не даст.

Тем не менее, в определенных условиях можно пренебречь качественными особенностями информации, выразить её количество числом, а также сравнить количество информации, содержащееся в различных группах данных. Физическую (термодинамическую, статистическую) и техническую (шенноновскую) информации, уменьшающие энтропию и неопределённость, измерить можно.

И в физическом и в техническом подходах к определению количества информации не обсуждается ценность того или иного информационного сообщения.

Меры информации бывают семантического, синтактического и прагматического уровня.

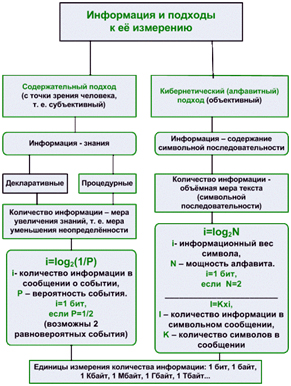

Подход к измерению информации бывает содержательным (вероятностным), который осуществляется через неопределённость знаний с учётом вероятности событий, или алфавитным, который осуществляется через количество символов с учётом информационного веса символов.

Подход к измерению информации бывает содержательным (вероятностным), который осуществляется через неопределённость знаний с учётом вероятности событий, или алфавитным, который осуществляется через количество символов с учётом информационного веса символов.

Смысловая информация всегда связана с материальным носителем: это может быть сигнал в любой материальной форме, числовой, символьный код на печатной основе и т.д. Информацию можно измерить, как и любой материальный объект. Количество информации, затраченное на описание конкретного объекта, можно оценить по количеству букв, затраченных на описание модели объекта. Поскольку, каждый символ естественного языка можно закодировать одним определённым числом информационных единиц (на один символ требуется 1 байт, т.е.8 бит), то легко вычислить полный объём информации, связанный с описанием любого объекта, процесса, явления. Это так называемый алфавитный подход измерения количества информации.

Есть другой количественный подход – технический (кибернетический, шенноновский), изложенный в работах К.Шеннона и Н.Винера. Изучая системы передачи информации, К.Шеннон пришёл к выводу, что каждое элементарное сообщение на выходе системы уменьшает неопределённость исходного множества сообщений, при этом смысловой аспект сообщения не имеет никакого значения. За единицу количества информации было предложено принять «количество информации, передаваемое при одном выборе между равновероятными альтернативами». Эта наименьшая единица информации называется бит.

Количество кодированной информации:

– мера информации, сообщаемой появлением события определенной вероятности;

– мера оценки информации, содержащейся в сообщении;

– мера, характеризующая уменьшение неопределенности, содержащейся в одной случайной величине относительно другой.

-

Единицами кодированной информации являются бит и байт.

Бит – минимальная единица измерения количества передаваемой или хранимой информации, соответствующая одному двоичному разряду, способному принимать значений 0 или 1.

Байт – в запоминающих устройствах – наименьшая адресуемая единица данных в памяти компьютера, обрабатываемая как единое целое. По умолчанию байт считается равным 8 битам. Обычно в системах кодирования данных байт представляет собой код одного печатного или управляющего символа.

Информация в один бит уменьшает неопределённость информационной системы в два раза. Для вычисления средней величины количества информации, связанного с положительным исходом некоторого события x из множества m событий К.Шеннон предложил формулу:

| Hx =−Σpi log pi, | (1) |

где pi -вероятность i-го события.

Эта формула характеризует энтропию (меру неопределённости) системы. Изначально это понятие появилось в физике, и характеризует оно степень неупорядоченности, т.е. неопределённости микросостояния, в котором система (например, термодинамическая) может находиться в данный момент времени. Значение Hx достигает максимума для равновероятных событий, т.е. при pi=1∕m формула К.Шеннона упрощается:

| Hmax = −log p = logm (формула Р.Хартли). | (2) |

Пример: Рассмотрим систему с 256 возможными состояниями, например, расширенную кодовую таблицу символов, тогда Hmax будет равно 8 битам (log2256 = 8). Другими словами, восемь бит достаточно, чтобы точно описать исход любого события (например, выборку определённого символа из таблицы).

Шеннон подошёл к проблеме как инженер и рассмотрел количество битов передаваемой в течение некоторого времени информации, т.е. её поток. Одной из особенностей такого подхода к определению понятия «информация» является то, что никак не учитываются энергетические или какие-нибудь иные ресурсные затраты, связанные с её передачей, приёмом и обработкой. В частности, процессы передачи и обработки информации и процессы, управляемые этой информацией, могут отличаться по энергетике во много раз. Здесь информация обсуждается как «надматериальная» субстанция, которая, тем не менее, упорядочена в физическом времени. Это следствие свойств информации, как возможность её передачи и преобразования посредством материальных носителей, в частности, возможность её запоминания и извлечения из памяти. Для сохранения информации необходимо «свёртывать» упорядоченную во времени последовательность сигналов в некоторые упорядоченные, структурные изменения в устройстве памяти. Извлечение же информации из памяти − обратный процесс восстановления упорядоченной во времени последовательности сигналов, с использованием тех структурных изменений в памяти, которые произошли при запоминании.

Передача информации через среду является частным случаем её преобразования: фактически, передача может рассматриваться как последовательное запоминание и восстановление сигналов от точки к точке пространства вдоль пути её распространения. Самый высокий уровень информационной энтропии имеют случайные последовательности знаков. Поскольку часть данных при преобразованиях информации может теряться, то передаваемая и принимаемая последовательности сигналов, или в ином, нетехническом контексте, − последовательности знаков, могут отличаться по информационному содержанию. Это отражено в соответствующих соотношениях, где учтено увеличение информационной энтропии в случае искажения части знаков при преобразованиях.

При термодинамическом подходе оценивается термодинамическая вероятность существования системы при каких-либо условиях до и после получения порции информации, а количество информации при этом оценивается через разность энтропий конечного и начального состояний, т. е. характеризует изменение уровня упорядоченности системы. Энтропия каждого состояния оценивается по формуле Больцмана:

| S=kln(N), | (3) |

где k − постоянная Больцмана, N − количество способов, которыми может быть реализовано данное состояние системы, а ln − натуральный логарифм.

Следует отметить, что однозначная связь между шенноновской и больцмановской формулами энтропии не всегда возможна хотя бы потому, что в одном случае речь идёт о потоке знаков, а другом − об изменениях в некоторой структуре. В качестве примера, когда это все же так, можно привести какое-нибудь устройство памяти, запоминающее короткие информационные сообщения.

Замечание. Существует ещё один способ определения количества информации, основанный на эпсилон-энтропии, предложен А.Н.Колмогоровым. Об алгоритмическом подходе Колмогорова к информации и о его теории сложности мы расскажем в одной из последующих лекций.

Есть так же содержательный (субъективный) подход к измерению информации. Содержание информации кроме количественного параметра имеет ещё и смысловую характеристику, которая определяется способностью пользователя понимать поступившее сообщение. Эта способность зависит от тезауруса пользователя, т.е. совокупности сведений и знаний, которыми располагает пользователь. Если тезаурус пользователя близок к нулю, то любая новая информация им не воспринимается (он её не понимает) и в этом случае семантическая компонента информации для него равна нулю (для меня, например, любой текст, записанный китайскими иероглифами будет давать нулевую информацию, тогда как для китайца (если он грамотен, конечно) тот же текст будет крайне информативен). Таким образом, одно и то же сообщение может нести для пользователя разное количество смысловой информации.

Подходы к определению понятия «количество информации», основанные на том, что информацию, содержащуюся в сообщении, можно нестрого трактовать в смысле её новизны или, иначе, уменьшения неопределённости наших знаний об объекте, не привели к особым успехам. Когда говорят о мере смысловой информации, обычно подразумевают не количество, а ценность информации.